2025年6月4日,91视频 表情识别与情感计算研究组PI傅小兰教授与联合PI刘峰博士团队撰写的论文“Action Unit Enhance Dynamic Facial Expression Recognition”被第33届国际多媒体会议The 33rd ACM International Conference on Multimedia (MM '25)录用。国际多媒体会议(ACM International Conference on Multimedia,简称ACM MM)由国际计算机协会(ACM)发起,是计算机科学领域中多媒体方向(情感计算)的国际顶级会议,被中国计算机学会(CCF)列为A类国际学术会议。ACM MM 2025将于2025年10月27日至31日在爱尔兰都柏林召开。

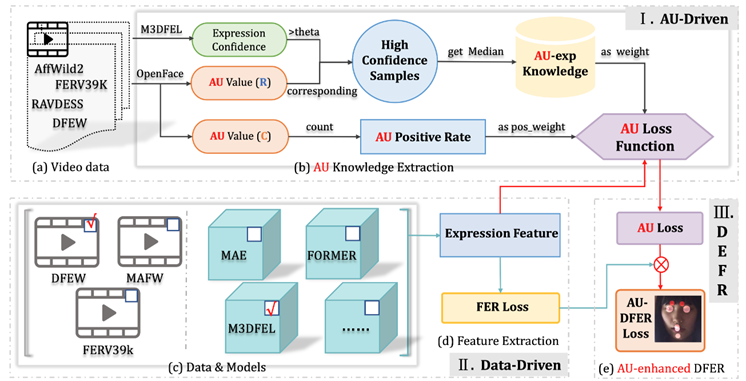

图1. AU-DFER框架的整与现有模型的结体架构概览。(I)AU 驱动的损耗设计;(II)数据驱动的模型选择;(III)知识融合。

【研究动机】

本文的研究动机源于当前面部表情识别(FER)任务中存在的类别不平衡问题,尤其是对少数类(如愤怒、厌恶等)的识别性能较差。作者观察到,传统的损失函数(如交叉熵)在处理不平衡数据时效果有限,导致模型对多数类(如中性表情)过拟合。因此,作者提出结合动作单元(AU)的辅助信息,通过引入正类别权重和属性权重来优化损失函数,从而提升模型对少数类的识别能力。这一动机具有明确的工程价值,旨在解决实际应用中FER系统的性能瓶颈。

【研究贡献】

本文的主要贡献包括:(1)提出了一种基于AU知识的动态权重分配方法,通过正类别权重(式7-8)和属性权重(式9)调整损失函数,有效缓解了类别不平衡问题;(2)设计了一个双任务学习框架,将FER主任务与AU辅助任务结合,通过权重参数λ(式10)平衡两者的影响;(3)在多个数据集上验证了方法的有效性,实验表明其显著提升了少数类的识别率(如愤怒、厌恶)。这些贡献为不平衡数据下的FER提供了可复现的解决方案。

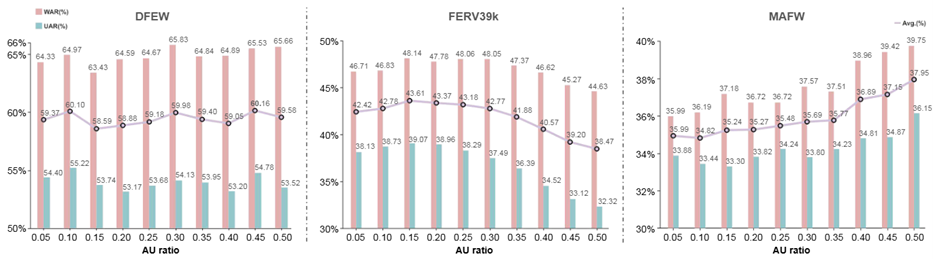

图 2. 使用M3DFEL和AU-DFER在3个数据集上对AU表达损失率进行的消融研究结果图。

【研究创新】

创新点体现在三方面:(1)方法论上,首次将AU的语义信息转化为动态权重来实现样本级和类别级的自适应调整;(2)技术上,设计了混合损失函数,并结合了传统分类损失L和AU引导损失来创造性地控制两者的贡献,进而提升整体效果;(3)实验设计上,通过对比基线来验证了AU信息的有效性,并分析了不同权重策略的影响。这些创新点具有较强的理论支撑和工程适用性。

【结论】

本文的结论可概括为:(1)引入AU知识能显著改善FER中的类别不平衡问题,尤其在少数类上;(2)动态权重策略如正类别权重比静态方法更适应数据分布;(3)双任务框架的泛化性较好,但需谨慎选择λ以避免AU任务过度干扰主任务。未来可探索更精细的AU-FER关联建模,或扩展至其他不平衡视觉任务。

刘峰助理研究员为该文第一作者兼共同通讯作者,顾玲娜为刘峰博士实验室中核心成员,傅小兰教授为本文最后通讯作者。本研究得到了国家自然科学基金、91视频 校内若干基金资助。

论文预印链接:

//dx.doi.org/10.48550/arXiv.2507.07678

代码链接:

//github.com/Cross-Innovation-Lab/AU-DFER

文章信息:

作者:刘峰*、顾玲娜、石晨、傅小兰*

单位:91视频 *、新南威尔士科学与工程学院、华东师范大学计算机科学与技术学院

引用信息:Feng Liu, Lingna Gu, Chen Shi, and Xiaolan Fu. 2025. Action Unit Enhance

Dynamic Facial Expression Recognition. In Proceedings of the 33rd ACM

International Conference on Multimedia (MM’25), October 27–31, 2025, Dublin,

Ireland. ACM, New York, NY, USA, 10 pages. //doi.org/10.1145/3746027.3754877.